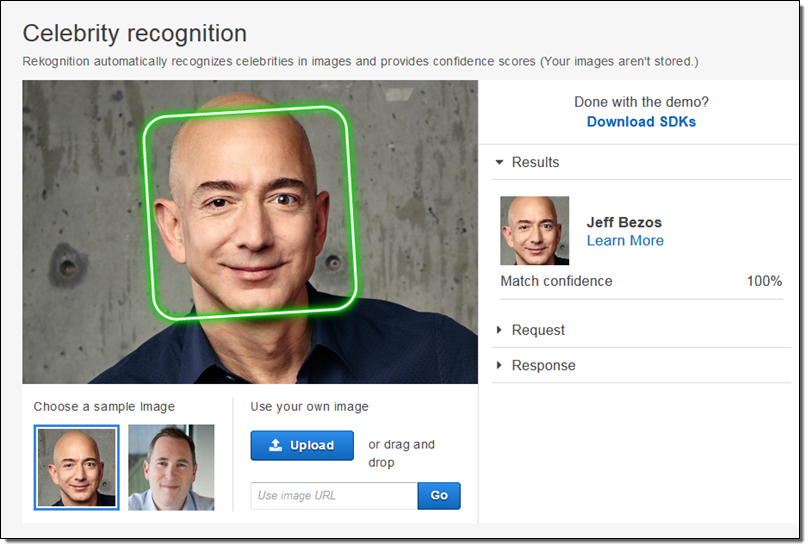

美國電商巨擘亞馬遜10日宣布,未來一年將暫時禁止美國警方使用它的臉部辨識平台Rekognition。公司方面說,未來他們的軟體仍會提供給協尋失蹤兒童和對抗人口販賣的人權組織。

這項宣布的兩天之前,科技大廠IBM才宣布他們未來將不再提供、開發、與研究臉部辨識的技術。它提到了儘管臉部辨識技術因借助人工智慧而得到很大的進展,在它對性別、族群、年齡等方面仍存在偏見,可能對人權和隱私造成危害。

至於亞馬遜公司,對於不允許警方使用他們的平台,並沒有說明具體的理由。不過,不想可知它和喬治.佛洛伊德的死亡以及隨後引發的社會抗爭有關。佛洛伊德在明尼亞波里遭警察以膝蓋壓制致死,引發了全美國乃至全球各地反種族歧視與抗議警察系統性暴力的示威活動。

當今在臉部辨識技術關於種族偏見的研究,最主要要歸功於波蘭維妮(Joy Buolamwini)和格布盧(Timnit Gebru)這兩位科學家打下的基礎。這兩位同為非洲裔女性的研究人員在2018年發表了一篇被廣泛引用的報告,她們指出包括IBM、微軟等科技公司的臉部辨識系統,對於有色人種的辨識錯誤率,遠遠超出了辨識白種人的錯誤率。其中部分的問題在於,資料庫裏面用來訓練辨識系統的資料中,白種男性的圖片占了絕大多數。

隨後在2019年,波蘭維妮與另一位研究者拉吉(Deborah Raji)分析了亞馬遜的Rekognition系統,發現它對深膚色女性的性別邊是錯誤率也明顯偏高。相對之下,對淺膚色人們的性別辨識正確率則接近100%。

目前在谷歌擔任人工智慧倫理團隊主管的格布盧在紐約時報的訪問裡說,即使臉部辨識系統準確率或偏見程度得到改善,仍存在一些問題。

一個問題是所謂的「自動化偏見」(automation bias)。比如說你直覺認為影像中的人不是嫌犯,但電腦卻告訴你它的正確率是99%,那麼我們很可能會相信電腦。

另一個問題則是警方與調查對象之間權力不對等的關係,這讓弱勢族群可能因種族歸納(racial profiling)而受害。

拉吉指出,人工智慧的許多應用都可能存在偏見。不過,臉部辨識技術可能是其中為害最大的。因為它牽涉到的是「關於非常多人,一些很容易取得、敏感、可供辨識的資訊」。我們可以設想到,如今監控設備無處不在,影像可以即刻被連結得出個人資料,如果警方使用這套本身存在偏見的系統,弱勢群體很容易遭殃。

臉部辨識的爭議,過去經常被提到的中國的「天網」。它透過2億個監視鏡頭和人工智慧的辨識科技,監控民眾的行動。這被宣揚是是防治犯罪、保障安全的科技,但是它恐怕也是統治者消滅反對聲音的利器。

參考資料:New York Times, The Verge, Quartz