「各位同學,你們手機的3D遊戲能連線互打、女朋友的美妝APP,可是跟AI有關喔,而AI能運作,則是跟伺服器(server)息息相關…」

去年暑假,一群來自香港的高中生特地來台前往新店參訪技嘉,介紹者是從技嘉網通事業分拆出來提供伺服器的技鋼台灣區產品行銷經理王昭力,為了讓大家了解時下超夯的生成式AI如何運作,現場擺了一台搭載輝達8張A100晶片伺服器,只見王昭力指著這款伺服器透露,「這一台要價可是相當於一台跑車,如果要玩ChatGPT,需要一萬台!」簡報一結束,同學們立刻衝上朝聖,一位男同學似乎頗了解市況,知道這顆晶片最近缺貨,還趁機調皮地摸一摸!

連高中生都知道—「ChatGPT」得靠輝達的繪圖處理晶片(GPU)來幫忙,但這跟以往電腦或傳統伺服器多以中央處理器(CPU)為主要架構似乎不同,究竟為何?

「過去的CPU 用伺服器, 7-8成工作都是儲存或搬運資料,但在AI架構下,有越來越多推論與分析資料的需求,CPU已無法滿足,原本早期只放在CPU下、用來加強圖像顯示的GPU,因為具有平行運算、可一次處理大量資料等特性,正好得以充分發揮。」工研院資通所總監徐銘鴻一邊詳細地說明,一開幽默的說,輝達就像撿到槍,成為這波AI浪潮下的主角,接著更生動地說形容,CPU好比用手指頭算數,GPU是計算機,同樣都能解題數學,手指頭要算來算去,按計算機一下子就能得到答案。

MIC資深分析師朱師右進一步向本刊補充,這次橫空出世的ChatGPT,因為得支援上千億個參數的大語言模型(LLM),要在短時間一次消化大量資料生成需要的回應,GPU的角色更是吃重。

不過,生成式AI帶動伺服器架構從CPU轉為GPU,輝達看似抓到時機,其實是十多年磨一劍結果。

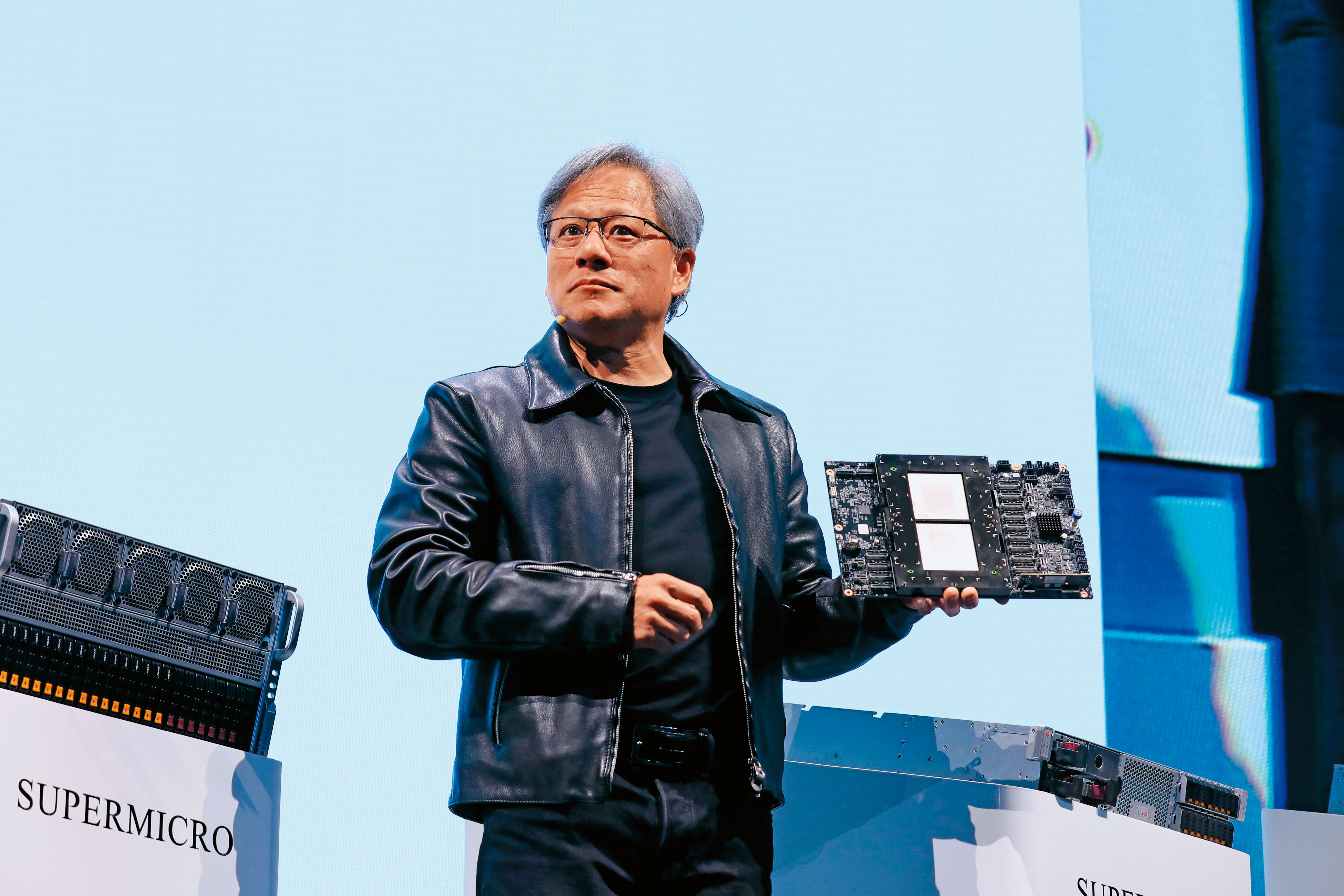

徐銘宏觀察,一般來說,AI包含三大項,分別是算力、算法跟場域(Domain),而輝達早從2007年就推出CUDA平台布建完整的生態圈,「你看Jason Huang(輝達創辦人黃仁勳)每年在辦開發展大會(GTC),跟各大學產學合作,就是在推這件事情(CUDA),無形中,也慢慢地把AI底層到應用所需的基礎建設建置成熟。」他更點出,這也是為何輝達至今拿下AI GPU市場6、7成佔有率的關鍵。

朱師右也補充,包含學校、企業終端這十多年已逐漸習慣用CUDA,儘管近期超微(AMD)也想透過RCOM平台與CUDA比拚,但如今的輝達就像蘋果的iOS,短期難以撼動,話鋒一轉,他仍對超微積極搶市樂觀其成,兩大業者力拱生成式AI,台灣身為伺服器王國,都是贏家。